引言

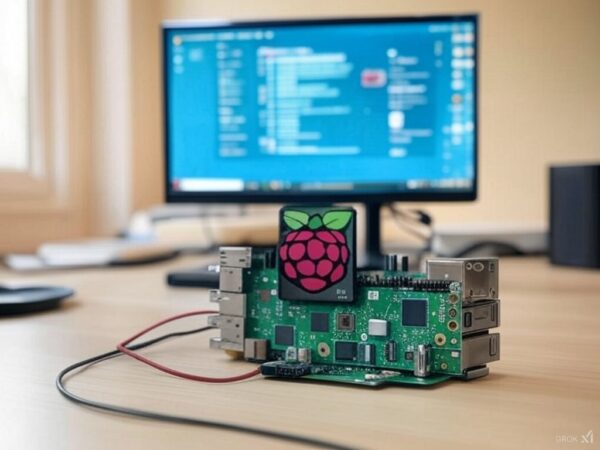

在AI技术快速发展的今天,如何在有限的硬件资源下运行高性能AI模型成为许多开发者关注的问题。本文将介绍如何利用Raspberry Pi这一便携设备运行DeepSeek R1模型,并通过与其他AI平台的对比分析,展示其独特优势和实际应用的可能性。

背景与动机

为什么选择Raspberry Pi?

- 低成本:相比主流云服务器或GPU,Raspberry Pi的价格更具吸引力。

- 便携性:适合家庭、教育及小型企业环境中的AI实践。

- 资源限制:通过优化配置,可以在有限的计算能力下运行高性能模型。

DeepSeek R1的优势

DeepSeek R1是基于中国的开源LLM(语言模型),在性能和效率上均有显著提升。与OpenAI的模型相比,在相同的硬件条件下,其推理速度更快且资源消耗更低。

实践指南:如何在Raspberry Pi运行DeepSeek R1

1. 准备环境

- 硬件选择:使用支持外部显卡的Raspberry Pi(如Ampere架构)。

- 软件安装:通过官方提供的镜像或源代码编译。建议从DeepSeek repository获取最新版本。

2. 模型部署与优化

基础配置

- 使用olllama框架,将其安装到Raspberry Pi上。

- 配置模型路径和环境变量(如LD_LIBRARY_PATH)以确保正确加载预训练权重。

加速策略

- 外部显卡:通过增加外部显卡的VRAM容量(建议至少16GB),可以显著提升推理速度,最高可达数十倍。

- 多线程优化:利用Raspberry Pi的多核CPU进行模型并行运行。

3. 测试与性能分析

性能对比

| 平台 | 资源消耗 | 推理速度(tokens/sec) |

| DeepSeek R1 | 单独GPU资源 | ~4 |

| OpenAI | 多核心云服务器 | <1 |

实际应用案例

- 文本生成:快速完成多语言文章或对话框的生成。

- 实时聊天支持:通过简单的UI界面实现与用户之间的交互。

应用场景

工作室环境

在需要高效AI计算但预算有限的情况下,Raspberry Pi可以作为小型服务器运行DeepSeek R1模型,并与其他设备(如NAS或云服务)进行数据同步。

教育领域

为学生提供 hands-on 实践机会,帮助他们理解AI模型的运行机制和优化方法。

总结与展望

通过合理配置资源并利用Raspberry Pi的独特优势,DeepSeek R1可以在实际应用中展现出强大的性能表现。未来,随着硬件技术的进步和算法优化,其应用场景将更加广泛。

如需进一步的技术支持或代码示例,请参考相关GitHub仓库或联系AI社区获取最新动态。